Le kappa de Fleiss est une mesure de concordance inter-évaluateur qui étend le Kappa de Cohen pour évaluer le niveau de concordance entre deux ou plusieurs évaluateurs, lorsque la méthode d’évaluation est mesurée sur une échelle catégorielle. Il exprime à quel degré la proportion d’accords observée entre les évaluateurs dépasse ce à quoi on pourrait s’attendre si tous les évaluateurs faisaient leurs évaluations de façon complètement aléatoire.

Par exemple, vous pourriez utiliser le kappa de Fleiss pour évaluer l’accord entre 3 médecins dans le diagnostic des troubles psychiatriques des patients.

Notez que le kappa de Fleiss peut être spécialement utilisé lorsque les participants sont notés par différents groupes d’évaluateurs. Cela signifie que les évaluateurs responsables de l’évaluation d’un individu donné ne sont pas supposés être les mêmes que ceux responsables de l’évaluation d’un autre individu (Fleiss et al., 2003).

Contents:

Livre associé

Concordance Inter-Juges: L'Essentiel - Guide Pratique dans RNotions de base

Formule

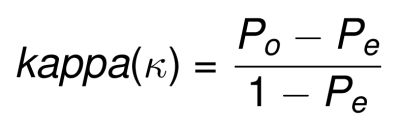

Brièvement, le coefficient kappa est une mesure de concordance qui supprime l’accord attendu dû au hasard. Elle peut s’exprimer comme suit:

- Po est l’accord observé

- Pe est l’accord attendu

Des exemples de formules pour calculer Po et Pe pour le kappa de Fleiss se trouvent dans Joseph L. Fleiss (2003) et sur wikipedia.

kappa peut varier de -1 (aucun accord) à +1 (accord parfait).

- lorsque k = 0, l’accord n’est pas meilleur que ce qui serait obtenu par hasard.

- lorsque k est négatif, l’accord est inférieur à l’accord attendu par hasard.

- lorsque k est positif, l’accord dépasse l’accord aléatoire.

Interprétation : Ampleur de l’accord

L’interprétation du kappa de Fleiss est comme celle du kappa classique de Cohen (Joseph L. Fleiss 2003). Dans la plupart des cas,

- des valeurs supérieures à 0,75 ou plus peuvent être considérées comme un excellent accord au-delà du hasard,

- des valeurs inférieures à 0,40 environ peuvent être considérées comme un mauvais accord au-delà du hasard, et

- des valeurs comprises entre 0,40 et 0,75 peuvent être considérées comme représentatives d’un accord juste à bon au-delà du hasard.

Pour en savoir plus sur l’interprétation kappa, voir (Chapitre @ref(cohen-s-kappa)).

Hypothèses

Vos données doivent répondre aux hypothèses suivantes pour le calcul du Kappa de Fleiss.

- Les variables de résultats retournées par les évaluateurs doivent être catégorielles (nominales ou ordinales)

- Les variables de résultats doivent avoir exactement les mêmes catégories

- Les évaluateurs sont indépendants

Hypothèses statistiques

- Hypothèse nulle (H0):

kappa = 0. L’accord est le même que l’accord aléatoire. - Hypothèse alternative (Ha):

kappa ≠ 0. L’accord est différent d’un accord aléatoire.

Exemple de données

Nous utiliserons les données de diagnostic psychiatrique fournies par 6 évaluateurs. Ces données sont disponibles dans le package irr. Au total, 30 patients ont été recrutés et classés par chacun des évaluateurs dans 5 catégories (Fleiss and others 1971) : 1. Dépression, 2. Trouble de la personnalité, 3. Schizophrénie, 4. Névrose, 5. Autre.

# install.packages("irr")

library("irr")

data("diagnoses", package = "irr")

head(diagnoses[, 1:3])## rater1 rater2 rater3

## 1 4. Neurosis 4. Neurosis 4. Neurosis

## 2 2. Personality Disorder 2. Personality Disorder 2. Personality Disorder

## 3 2. Personality Disorder 3. Schizophrenia 3. Schizophrenia

## 4 5. Other 5. Other 5. Other

## 5 2. Personality Disorder 2. Personality Disorder 2. Personality Disorder

## 6 1. Depression 1. Depression 3. SchizophreniaCalculer le kappa de Fleiss

La fonction R kappam.fleiss() [package irr] peut être utilisée pour calculer le kappa de Fleiss comme indice d’accord inter-évaluateurs entre m évaluateurs sur des données catégorielles.

Dans l’exemple suivant, nous allons calculer l’accord entre les 3 premiers évaluateurs:

library("irr")

# Sélectionner les trois premiers évaluateurs

mydata <- diagnoses[, 1:3]

# Calculer kapa

kappam.fleiss(mydata)## Fleiss' Kappa for m Raters

##

## Subjects = 30

## Raters = 3

## Kappa = 0.534

##

## z = 9.89

## p-value = 0Dans notre exemple, le kappa de Fleiss (k) = 0,53, ce qui représente un accord assez-bon selon la classification de Fleiss (Fleiss et al. 2003). Ceci est confirmé par la p-value obtenue (p < 0,0001), indiquant que notre kappa calculé est significativement différent de zéro.

Il est également possible de calculer les kappas individuels, qui sont des kappa de Fleiss calculés pour chacune des catégories séparément par rapport à toutes les autres catégories combinées.

kappam.fleiss(mydata, detail = TRUE)## Fleiss' Kappa for m Raters

##

## Subjects = 30

## Raters = 3

## Kappa = 0.534

##

## z = 9.89

## p-value = 0

##

## Kappa z p.value

## 1. Depression 0.416 3.946 0.000

## 2. Personality Disorder 0.591 5.608 0.000

## 3. Schizophrenia 0.577 5.475 0.000

## 4. Neurosis 0.236 2.240 0.025

## 5. Other 1.000 9.487 0.000On peut constater qu’il y a un accord de passable à bon entre les évaluateurs en ce qui concerne l’évaluation des participants comme souffrant de “dépression”, de “trouble de la personnalité”, de “schizophrénie” et “autre” ; mais il y a un mauvais accord quant au diagnostic de la “névrose”.

Rapporter

Le kappa de Fleiss a été calculé pour évaluer l’accord entre trois médecins dans le diagnostic des troubles psychiatriques chez 30 patients. Les trois médecins étaient assez d’accord, kappa = 0,53, p < 0,0001. Les kappas individuels pour les catégories “dépression”, “trouble de la personnalité”, “schizophrénie”, “névrose” et “autre” étaient respectivement de 0,42, 0,59, 0,58, 0,24 et 1,00.

Résumé

Ce chapitre explique les bases et la formule du kappa de Fleiss, qui peut être utilisé pour mesurer l’accord entre plusieurs évaluateurs qui évaluent avec un score catégoriel (nominales ou ordinales). Nous montrons également comment calculer et interpréter les valeurs de kappa à l’aide du logiciel R. Notez qu’avec le kappa de Fleiss, vous n’avez pas nécessairement besoin d’avoir les mêmes ensembles d’évaluateurs pour chaque participant (Joseph L. Fleiss 2003).

Une autre alternative au Fleiss Kappa est le kappa de Light pour calculer l’indice de concordance inter-évaluateurs entre plusieurs évaluateurs sur des données catégorielles. Le kappa de Light est juste le Kappa moyen de Cohen (Chapitre @ref(cohen-s-kappa)) si vous utilisez plus de 2 évaluateurs.

References

Fleiss, J.L., and others. 1971. “Measuring Nominal Scale Agreement Among Many Raters.” Psychological Bulletin 76 (5): 378–82.

Joseph L. Fleiss, Myunghee Cho Paik, Bruce Levin. 2003. Statistical Methods for Rates and Proportions. 3rd ed. John Wiley; Sons, Inc.

Version:

English

English

No Comments